Las alucinaciones en la inteligencia artificial (IA) se refieren a situaciones en las que un modelo de IA genera información incorrecta, inventada o sin fundamento en los datos de entrenamiento. Estas «alucinaciones» son especialmente comunes en modelos de lenguaje basados en IA generativa y se manifiestan como respuestas factualmente erróneas, afirmaciones imaginarias o fuentes ficticias.

Causas de las alucinaciones en IA:

- Generalización incorrecta: La IA puede extrapolar información más allá de lo aprendido, generando datos falsos o mezclando conceptos de forma incorrecta.

- Falta de contexto adecuado: Si el modelo no comprende bien el contexto de la pregunta, puede responder de manera incoherente.

- Ruido en los datos de entrenamiento: Datos ambiguos o contradictorios en el conjunto de entrenamiento pueden llevar a la generación de respuestas erróneas.

- Optimización orientada a fluidez: Algunos modelos están diseñados para producir texto fluido y coherente, lo que a veces prioriza la forma sobre la precisión.

- Limitaciones del conocimiento estático: La IA entrenada hasta cierto punto en el tiempo puede inventar datos para suplir la falta de información actualizada.

Ejemplos de alucinaciones:

- Inventar hechos o referencias: Decir que un autor publicó un libro que nunca existió.

- Confundir conceptos: Mezclar eventos históricos de manera incorrecta.

- Crear citas o referencias académicas falsas: Incluir un DOI o referencia que no corresponde a ningún artículo real.

Soluciones en desarrollo:

- Modelos híbridos con fuentes verificables: Vincular las respuestas a bases de datos o fuentes fidedignas.

- Validación humana: Revisión de las respuestas generadas por IA en aplicaciones críticas, como en medicina o derecho.

- Mejor entrenamiento y curación de datos: Filtrar datos más precisos y relevantes para reducir sesgos y errores.

Las alucinaciones son un desafío significativo en la IA.

Hoy comparto una reflexión sobre el uso de la inteligencia artificial, en particular sobre un fenómeno denominado «alucinaciones». Este concepto se refiere a la capacidad de las IA para generar respuestas o contenidos que, aunque aparentemente plausibles, carecen de una base factual. En el video que acompaña esta publicación, presento un ejemplo de cómo se manifiestan estas alucinaciones, a partir de un ejercicio realizado en un diplomado en Inteligencia Artificial.

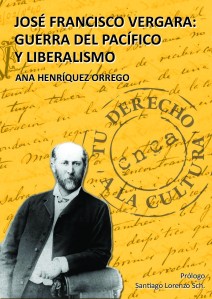

El ejercicio se centra en una consulta sobre un personaje histórico chileno del cual poseo un conocimiento profundo: José Francisco Vergara, fundador de Viña del Mar y figura relevante en la Guerra del Pacífico. Para ilustrar el comportamiento de dos modelos de IA, solicité a Géminis y a ChatGPT en su versión Canva que generaran un texto breve con referencias bibliográficas sobre Vergara.

Los resultados fueron reveladores. ChatGPT produjo un texto bien estructurado, con citas en formato APA que, a simple vista, parecían válidas. Sin embargo, al analizarlas, se aprecia que ninguna de ellas existe realmente. Estas citas son invenciones, alucinaciones sin respaldo factual, lo cual es problemático, ya que el formato adecuado puede inducir a error a los usuarios menos experimentados, quienes podrían asumir que la información es veraz.

Por el contrario, Géminis entregó una respuesta más concisa, pero mucho más precisa. Las referencias proporcionadas eran reales y verificables, aunque menos numerosas. Esta comparación muestra la importancia de ser críticos con la información generada por IA, especialmente en contextos educativos, donde la precisión es esencial.

Al utilizar herramientas de inteligencia artificial, debemos recordar que no siempre actúan como «compendios de la verdad». Pueden inventar, y si no verificamos la información, corremos el riesgo de obtener datos incorrectos. Esto es especialmente relevante en el ámbito académico, donde el conocimiento erróneo puede tener consecuencias significativas.

Mi recomendación para estudiantes y académicos que utilicen estas herramientas es actuar siempre con cautela: verificar las fuentes, proporcionar un contexto adecuado y no asumir que todo lo que genera la IA es preciso. La capacidad creativa de la IA puede ser un activo valioso en la creación literaria o musical, pero cuando buscamos conocimiento objetivo, necesitamos un enfoque crítico y responsable.

Les invito a ver el video donde exploro estas diferencias entre Géminis y ChatGPT y reflexiono sobre cómo abordar las alucinaciones de la IA de manera consciente. Creo que es una discusión importante para todos los interesados en tecnología y educación.

Ana Henriquez Orrego